抖音背后的数字巨人 解析亿级用户并发的服务器架构与带宽之秘

当上亿用户同时滑动屏幕,观看短视频、直播互动时,支撑这一切流畅体验的,是抖音背后庞大而精密的数字基础设施。要理解抖音如何服务如此庞大的用户群体,我们需要从带宽需求、数据处理架构和分布式系统设计三个维度进行解析。

带宽需求:数字洪流的承载者

抖音的服务器带宽并非单一数字,而是由全球数百个数据中心、边缘节点和内容分发网络(CDN)共同构成的庞大体系。根据行业估算和公开数据,我们可以窥见其规模:

核心指标估算:

- 单用户平均带宽需求:标清视频约1-2Mbps,高清视频约3-5Mbps,4K视频可达15-25Mbps

- 并发用户峰值:按日活用户7亿计算,假设30%同时在线(约2.1亿),其中50%正在观看视频(约1亿)

- 带宽总量需求:按平均3Mbps计算,仅视频流就需要约300Tbps的带宽容量

这还只是视频流的带宽需求,不包括直播互动、评论加载、消息推送等数据交换。抖音实际部署的总带宽容量可能达到500Tbps以上,相当于同时传输数百万部高清电影的数据量。

数据处理架构:智能调度的大脑

如此巨大的带宽需求并非简单堆砌服务器就能实现,而是依靠精密的架构设计:

1. 多层级CDN网络

抖音在全球部署了数千个CDN节点,形成"中心-区域-边缘"三级分发体系:

- 中心节点存储全量内容,处理上传和转码

- 区域节点服务大区用户,缓存热门内容

- 边缘节点直接面向用户,实现毫秒级响应

2. 智能调度系统

实时监控全球网络状况和用户位置,动态分配流量:

- 基于用户IP和网络状况选择最优节点

- 高峰期自动启用备用线路和节点

- 故障时毫秒级切换,用户无感知

3. 视频编码优化

采用先进的视频压缩技术(如H.265/HEVC、AV1):

- 同等画质下带宽节省30-50%

- 自适应码率技术,根据网络状况动态调整画质

服务器集群:分布式的力量

抖音的数据处理服务建立在百万级服务器集群之上:

计算资源分配:

- 视频转码集群:处理上传视频的转码任务

- 推荐引擎集群:实时计算用户偏好,个性化推荐

- 存储集群:分布式存储海量视频文件

- 实时通信集群:支持直播连麦、消息同步

技术创新:

1. 边缘计算:将部分计算任务下沉到离用户更近的节点,减少回源流量

2. 智能预加载:基于用户行为预测,提前缓存可能观看的视频

3. 多协议支持:同时支持HTTP/2、QUIC等现代传输协议,优化弱网体验

4. 全球负载均衡:根据地理位置、网络质量、服务器负载等多维度智能路由

运维挑战与应对策略

服务亿级并发用户面临诸多挑战:

峰值管理:节假日、重大事件期间流量可能暴增2-3倍

- 解决方案:弹性伸缩架构,按需自动扩容

成本控制:带宽和服务器成本巨大

- 优化策略:深度压缩、智能缓存、闲时资源复用

稳定性保障:任何故障都可能影响数百万用户

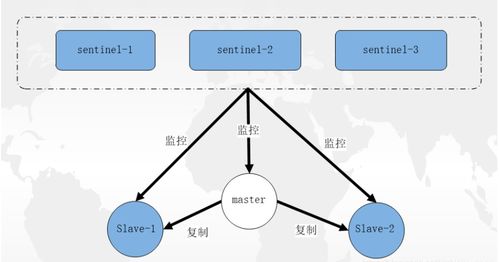

- 容灾体系:多活数据中心、跨地域冗余、自动化故障切换

未来演进方向

随着5G普及和8K视频兴起,抖音的基础设施也在持续进化:

- 向边缘计算深度迁移,进一步降低延迟

- AI驱动的带宽预测和动态分配

- 与运营商合作部署边缘节点,实现"网随人动"

- 探索P2P分发技术,利用用户设备资源

##

抖音能够服务上亿用户同时在线,不仅是带宽数量的胜利,更是架构设计、算法优化和运维体系的综合体现。这个数字巨人通过智能调度将全球计算资源编织成一张无缝的网络,让每个用户都能获得流畅的体验。在可见的随着技术进步和用户需求增长,这个数字基础设施还将继续扩展和进化,支撑更加丰富的互动形式和更高质量的内容体验。

注:具体带宽数字属于商业机密,本文数据基于公开信息和行业估算,实际部署可能有所不同。

如若转载,请注明出处:http://www.bdanbao.com/product/61.html

更新时间:2026-02-25 03:57:39